TIMSS数学测评系统的构建,主要目的在于了解各个参加测评的国家在数学学业成就上的表现情况,同时进一步了解学生数学学业成就的影响因素及其存在的差异,希望通过该测评能更多地获取有关数学课程、教学实践与高水平学生学业成就之间的相关信息,从而改善全球数学的教与学。TIMSS数学测评自1995年开始运作,虽中途有过不断调整,但这个初始目标始终没有发生变化。

下面分别就认知、观察和解释三个维度,对TIMSS数学测评的历年表现进行梳理。

(一)认知维度

本部分尝试归纳梳理历年TIMSS数学测评在目标和相关维度上的设计变化。

1.1995年的认知维度

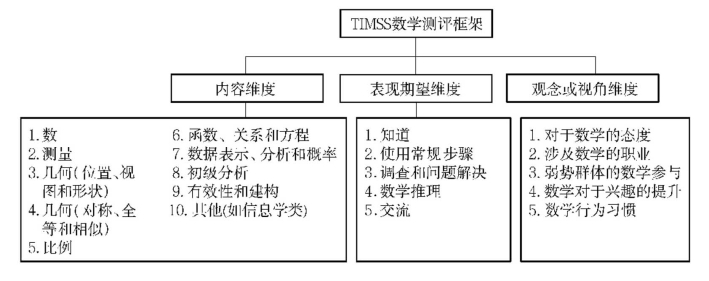

在上面的叙述中可以注意到,TIMSS测评在整体设计上,以课程作为学生学业结果的影响因素。1995年的TIMSS数学测评考虑到,无论是预期课程、实施课程还是达到课程,都包含概念、过程和态度三个方面。基于此,构建了测评的内容、表现期望和观念或视角作为三类课程的分析维度,相应框架如图4-2所示。

图4-2 1995年TIMSS数学测评框架

这种组织性结构改变了早期典型的内容—认知行为的两维组织框架。SIMS测评在三类课程基础上,完全以这个组织结构建立并整理测评。在整个数学教育领域,类似这样的两维框架被广泛使用,主要受到布卢姆分类目标,特别是教育专家威尔逊(J.W.Wilson)相关工作的影响。[9]

内容—认知行为的两维组织架构,一定程度上可以直接指向试题的双向细目表,在国外称为考试蓝图。该表就是两维的矩阵形式,水平维度显示学生完成试题所体现的、具有层级性的认知层次,纵向维度显示学生数学内容主题或内容领域。试题在矩阵中往往处于某一格子中,代表着该试题要测试的学生某一数学领域或主题,学生完成试题需有一定的认知层次水平。这种两维的组织框架,在TIMSS前期的测试中已经使用,并为不同的参与测试国家提供了一个公共的分析平台,来分析三种不同层次的课程表现,甚至体现使用课程和获取课程之间的联系性。

但是这种框架也暴露了不足之处,就是无法充分体现不同内容领域之间,或不同认知层次之间的相互内在联系,这使得相关信息描述处于断裂或相互隔绝的状态中。甚至有人质疑这种框架用来刻画课程特征是否合适,质疑在反馈学生如何学习相关学理应用的灵活性上是否适用。[10]显然,便于课程分析的组织框架,不仅需要一定的复杂性,而且需要一定的灵活性,以至于能对涉及国际范围课程的相关变量作出有意义的描述。上述两维的组织框架既不能很好体现原有的测评目标,也不能很好解释测评结果,局限性非常明显。

上述内容维度和表现期望维度与SIMS中的内容—认知行为对应,区别在于,在不同的维度内分别呈现一系列内容或子目录,在同一个维度内的内容不刻意或特别强调层级性,甚至允许有一定的重叠性存在。观念或视角维度,则试图与相关学科文本,如对教材等的分析关联起来。期望通过相关材料案例,或其呈现的前后内容中所体现的学科特性,对课程的相关成分,甚至学生的态度等进行归类。

这既保持了SIMS在课程影响变量上的相应设计,做到了测评的延续性,同时也克服了内容—认知行为两维组织框架的局限性。试题归类到每个维度内的多个内容,也可以归类到不同的上述维度中。这在一定程度上打破了布卢姆分类目标层级性所容易产生的包含和被包含关系,同时打破了同一个维度内相互割裂的状态。

1995年TIMSS数学测评框架的具体内容如图4-3所示:

图4-3 1995年TIMSS数学测评框架的具体内容

概括叙之,在内容领域,有以下主题。

·数:数的意义,分数和小数,整数、比和实数,其他数和数的概念,估计和数感;

·测量:单元,周长、面积和体积,估计和误差;

·几何(位置、视图和形状):二维的坐标几何,几何基础、多边形和圆,三维几何,向量;

·几何(对称、全等和相似):变换,全等和相似,尺规作图;

·比例:比例的概念,比例问题,坡比和三角,线性插值和外推;

·函数、关系和方程:图式、关系和函数,方程和公式;

·数据表示、分析和概率:数据表示和分析,不确定性和概率;

·初级分析:无限过程,变化;

·有效性和建构:有效性和说理,建构和抽象;

·其他:信息。

在表现期望领域,有以下行为。

·知道:表示,识别相等,回忆数学事实和性质;

·使用常规步骤:使用工具,使用常规步骤,使用更复杂过程;

·调查和问题解决:形成、归类问题和情境,设计策略,解决,预测,证明;

·数学推理:设计标记和相应词汇,设计运算法则,概括,推测,推理和证明,公理化;

·交流:使用词汇和标记,联系表达,描述或讨论,评论。

上述呈现的该框架及其具体内容和表现期望,是针对三个群体所建立的共同框架。内容维度指的是TIMSS数学测评所关心的数学课程内容或试题所要呈现的内容。表现期望维度是早期的认知行为维度的重构,力求以一种非层级性的呈现方式,来描述学生在试题或课程单元中的各种表现和行为。[11]

该框架建立在原有的概念框架(即分析课程对于学生学习结果的影响,建立预期课程、实施课程和达到课程,此处定义为纵向框架)的基础上。为便于分析课程内部对于学生学习结果的影响,对不同层面课程的影响进行了分析,考虑了内容、表现期望、观念或视角三个要素或维度的分析框架(此处定义为横向框架)。这使得框架不再是死板的、两维矩阵式的表现形式,体现出多种表现形式。从量化表现形式而言,一道试题可能是上述三个要素构成的三维向量,同时对于每个要素,该试题可能呈现出多维度的趋势。这两者的整合,从框架设计角度,多维度、多侧面、多变量地考查了学生学习结果的影响因素,特别是课程对于学生学习结果的影响。对于课程的构成要素、不同国家的数学教学改革和实践中学生学习活动的多样性,以及伴随着各国课程改革而出现的测评形式,学生所表现出的新的情况和新的信息,这样的框架设计显然体现出较强的灵活性和适应性。

可以看到,TIMSS的组织框架不断地尝试从一系列课程视角或相关变量对课程和课程的变化进行分析,同时根据现有的试题或设计的教学活动所固有的复杂性进行分类,且不会一味迎合那些简单的分类形式,避免了在相应呈现材料中扭曲或丧失学生所蕴含的体验或经历。这样做既明晰了原有测评系统的设计目标,又为后面的试题表征及解释奠定了基础。

1995年形成的上述TIMSS测评框架,为以后的TIMSS数学测评框架奠定了基础。在以后几轮的测评中,基本上没有发生根本性变化,最多在维度的内容上进行若干调整。

2.1999年的认知维度

时隔四年后,TIMSS再一次进行了测评,但仅仅针对8年级的群体。因此,该年的TIMSS测评又被称为TIMSS-Repert或TIMSS-R,可以被看作对1995年测评的延续。该测评在保持原有测评目的的同时,基本保留了原有的测评框架,包括原有内容分类(在最后的数学内容报告类别中,与1995年相比减少了“比例”部分的内容)、表现期望及观点分类。

3.2003年的认知维度

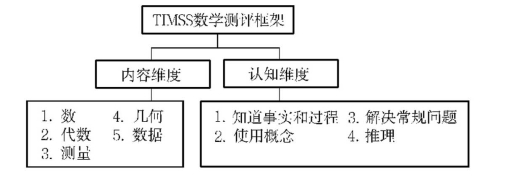

2003年的TIMSS测评保持了1995年、1999年测评的目标。由于两次TIMSS测试数据的获得,以及相关背景数据整合成趋势数据信息链,形成了有关教育政策和实践层面变化的动态图景,为比较和改善各国教育系统、提升数学和科学教育的质量提供了新的研究途径。[12] 2003年的TIMSS沿用了1995年、1999年的概念性框架,即课程模型(含预期课程、实施课程、达到课程的纵向框架),同时将原有的横向框架修改为内容和认知两个维度,如图4-4所示。

图4-4 2003年TIMSS数学测评框架

内容和认知两个领域的维度同时适用于4、8两个年级,但在内容领域中,不同的内容主题各有侧重。内容维度的呈现,与1999年的数学报告类型基本一致,而不是沿用1995年更为细琐的分类,主要考虑到便于将前两次的相关试题直接纳入2003年的实际使用框架之中,报告使用的内容分类和原有的内容分类基本统一。这是与1995年和1999年的TIMSS不一样的地方。在美国NSF的资助下,2003年对内容维度进行了重新梳理,将各国近十年的数学课程内容变化重新归纳、整理进来,并借此调整了相关内容主题的比重。下面谈到试题分布时,会有比较明显的显现。

认知维度表示的是所需技能和能力,与原有的表现期望不同的是,少了问题解决和交流。TIMSS团队认为问题解决和交流是数学教育中的重要结果,它与内容领域中的许多主题相联系。它们是通过大部分主题内容领域的试题所引发的有效行为,是内容和认知维度所需要的重要基础,故不在认知维度进行单列。[13]

概括叙之,在内容领域,有以下主题。

·数:数的意义,分数和小数,整数,比、比例和百分比;

·代数:认识的范式,代数表达,方程/公式,关系;

·测量:属性及单位,工具、技术及公式;

·几何:线和角,二维和三维图形,全等和相似,定位和空间关系,对称和变换;

·数据:数据的收集和组织,数据表达,数据解释,不确定性和概率。

在认知领域,有以下行为。

·知道事实和过程:回忆,识别,计算,回复,使用工具(主要指数学和测量工具);

·使用概念:知道,区分,表示,阐述,区别;

·解决常规问题:选择,建模,应用,检查和确认;

·推理:假设/推测,分析,评价,概括,连接,综合/整合,证明,解决非常规问题。

2003年的整个目标分析框架发生了很大变化。其一,目标分析框架中不再单列观点,但这并不是说明观点不重要,主要是考虑将对数学的兴趣、态度、动机等纳入学生结果影响分析模型中,作为学生个人因素的一部分,并不再单独显现出来。其二,进一步筛选学生认知结构中的相关维度,排除了对“问题解决”和“交流”能力的需求,保持了认知中对数学思考,如概念、推理的关注。

4.2007、 2011年的认知维度

在前几轮的测评中,有一个问题一直困扰着TIMSS设计团队,即根据现有的数学测评内容、认知框架,除了要对内容领域建立精熟度量尺之外,如何建立学生认知领域的相关量尺?进一步了解、分析学生解决试题过程中使用认知能力的情况,成为2007年TIMSS数学测评设计和研发的重点。

在2003年及之前共三轮的数学测评报告中,都没有纳入认知方面的量尺及报告。在实际试题设计和归类过程中,现有认知领域的分类不够清晰,如并不能很清晰地区分“知道事实和过程”和“使用概念”这一认知领域中的两个维度。

鉴于上述目标和实际现状,由美国牵头,IEA的TIMSS国际研究中心组织各国及各学科专家,协调从2005年开始的相关研究。从便于区分或分类试题的角度,专家团队决定充分考虑大多数学生使用的认知过程,建立相关的认知领域:知道事实和过程、概念;应用知识和理解;推理。[14]美国NCES利用TIMSS 2003的相关信息及数据,在新认知领域进行重新分析,其结果经过各国的国家研究中心和数学学科专家团队论证,最终形成了2007年TIMSS数学测评的内容和认知领域。这保证了TIMSS总体框架与2003年的衔接,同时更便于试题分类,为后期的IRT技术分析奠定了扎实基础。在不改变原有课程框架设计(预期课程、实施课程和达到课程)的基础上,形成了整体如图4-5的8年级TIMSS数学测评框架(这个框架在2007、2011年的TIMSS数学测评中得以使用)。

图4-5 2007、2011年TIMSS数学测评框架

这两轮TIMSS数学测评,在8年级的内容领域,有以下主题。

·数:数的意义,分数和小数,整数,比、比例和百分比;

·代数:认识的范式,代数表达,方程/公式和函数;

·几何:几何图形,几何测量,定位和移动;

·数据和机会:数据的组织和表达,数据解释,机会(概率基础)。

在认知领域,有以下行为。

·知道事实和过程、概念:回忆,识别,计算,回复,测量,归类或排序;

·应用知识和理解:选择,表示,建模,实施,解决常规问题;

·推理:分析,概括,综合/整合,证明,解决非常规问题。

与以往TIMSS数学测评的内容和认知领域不同,这两轮TIMSS数学测评首次将内容领域按不同年级罗列,具体维度各有不同。在认知领域的维度虽然相同,但不同年级之间各有侧重。认知领域的三个维度——知道事实和过程、概念,应用知识和理解,推理分别简称为“知道”“应用”“推理”。这三个认知维度,主要是从问题的解决角度去考虑。“知道”主要侧重于问题解决所需的基础性知识,如对基本概念和事实的所知;“应用”主要侧重于常规性问题,如各国课程教材中熟悉的“习题”,即使是有实际情境的问题,也是经过一定编辑和适当修正的“拟实际”型问题;“推理”主要侧重于复杂的非常规性问题。从这里,可以看出TIMSS数学测评在认知方面还是注重试题所体现的相关特征——常规和非常规,而不是纯粹从问题解决的过程去考虑。

综上所述,TIMSS数学测评在“认知”分析维度上的发展变化,构建起了内容和认知(或表现期望)的目标分析框架。但是,由于重心在于内容中不同维度的构建,如何体现各国数学课程上的不同内容分布及权重?此外,随着测评时间的年轮增加,还得关注各国数学课程的相应变化。为了便于试题在内容上体现出一定的关联性,该测评在内容、主题方面不断进行整合,最终形成数、代数、几何、数据和机会四个内容维度。在认知领域,该测评着重体现试题所引起的行为特征的归类和描述。虽然淡化了布鲁姆认知分类目标的层级性,但是不可否认,在认知的不同维度上,行为描述还是深受其影响。如2011年认知领域的描述尤为明显,层级性跃然纸上。值得注意的是,TIMSS数学测评在认知领域发展后期注意到了从问题解决的角度去考虑,但是它更多地是考虑解决问题的类别,而不是问题解决的过程。

(二)观察维度

这部分内容主要是归纳和梳理TIMSS数学测评在内容、表现期望及题型上的题量分布和试题特征表现,涉及测评蓝图、题型及编码三个方面。通过这三个方面的梳理,凸显了试题对于上述测评目标及维度的表现。同时,TIMSS数学测评的试题可以看作预期课程与测评相关内容之间的联系。

1.1995年的观察维度

(1)测评蓝图

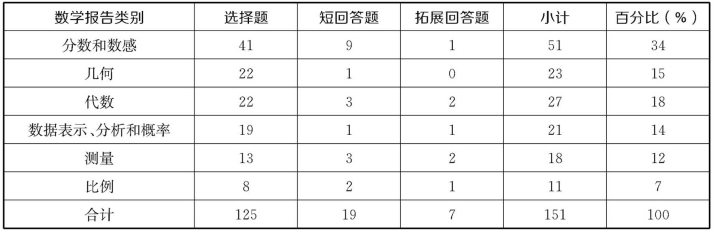

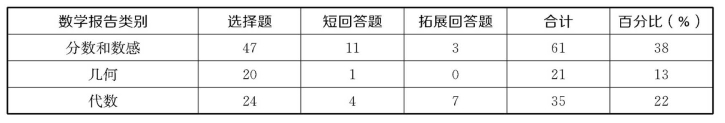

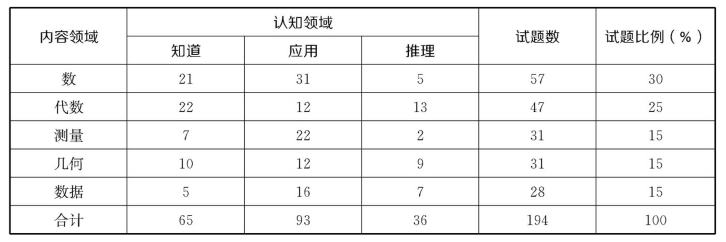

这里就测评的数学报告类别与题型、数学内容与表现期望分别进行归类,形成表4-2与表4-3。

表4-2 1995年TIMSS数学报告类别与题型有关题量交叉表[15]

表4-3 1995年数学内容类别与表现期望有关测试时间交叉表[16]

上述表格,实际上是TIMSS数学测评最终的实施蓝图。这个蓝图安排了整个测评相关的数学内容、表现期望及题型题量分布。这个工作显然对测评系统维度的体现和试题设计起到了承前启后的作用。

在TIMSS就各个国家的预设课程进行文献分析及完成TTM时就着重注意这个工作。除了在文献分析中详细地收集各国相关年级学生学习的数学信息外,TTM为研究人员提供了各个国家在数学框架中不同内容主题的发展变化(从初始到结束),并关注课程文本中不同主题的子部分,力求体现不同年级数学内容上的宽度和深度。这些信息基本确定了各个国家在每个内容主题上的比重,然后通过在这些参加测试的国家之间大致取一个平均数,来获得每个内容主题在TIMSS测试中的所用时间比重。通过估计不同题型所用时间,最终确定TIMSS数学测试中不同内容、主题的题量和不同表现期望上的题量分布。鉴于信息收集和资源的局限性,不是每个试题的设计都能面面俱到,全面覆盖每个内容主题,因此将相关内容主题或子主题适当整合,形成了“数学报告类别”,以便分析和形成结果报告。如群体2中,将主题“数”的子主题“分数和小数”中的“一般分数:意义和表示”“一般分数:操作、联系和性质”“小数”及“估计和数感”合成一个报告类别“分数和数感”;将“几何:全等和相似”“其他几何”合成“几何”;将“代数:线性方程”“其他代数”合成“代数”;将“数据表示和分析”“概率”合成“数据表示、分析和概率”等。这个工作在最后成型过程中,由负责TIMSS的国际研究中心下属的课程委员会进行适当修订,并由各国国家研究合作委员会最后确定。

通过上述比较冗长的文字表述,我们看到,为了在各个国家间学生学业成就上进行科学合理的比较,并将课程作为主要的影响因素考虑,TIMSS在试题设计阶段或测评工具形成初始,其测评蓝图的构成就已经充分考虑到各国预期课程的特征情况,保证了TIMSS数学测评工具与各个国家课程较佳的契合程度。

(2)题型

结合TIMSS的框架,对于认知期望中所涉及的高级认知提出了新要求,特别对于进一步要求了解和获取过程信息提出了更大的期望,如问题解决、证明和交流等。这些不是选择题所能考查到的,即使选择题在测评管理中可靠性和有效性较高。在以往两次数学测评的基础上,TIMSS在适当保留选择题的同时,在笔试中设计了一种新的题型:开放性回答题。该题型又分两类:短回答题(相当于我国的填空题)和拓展回答题(相当于我国的解答题)。对于短回答题,学生往往只需用简单的词或数字来表示答案,无需写出具体过程,评分过程中也只需判断对或错。对于拓展回答题,则不仅需要学生呈现具体的过程,而且因为评分过程相应呈现多级特点,所以需要评分人员根据学生的实际回答情况,适当归类转化为与评分标准相应的评分要点。TIMSS就具体评分量规的形成,进行了专门的研究。由于评分量规的制定涉及测评目标和试题表征之间的联系,相应内容专门就评分量规的制定进行了论述。

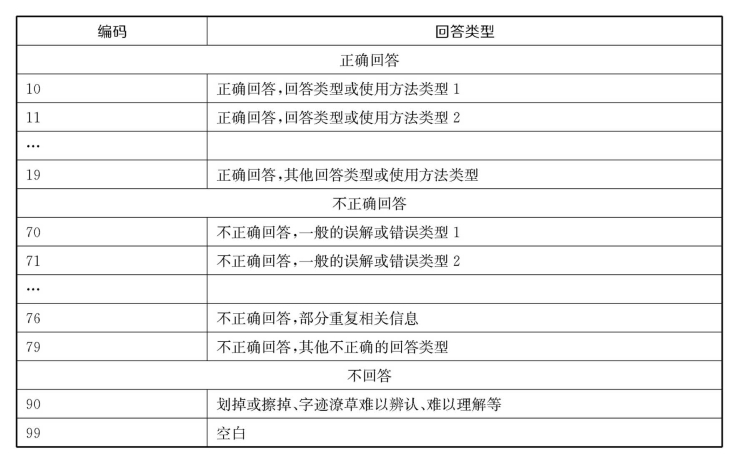

(3)开放性回答题编码

开放性回答题编码与国内所指的评分相比是有区别的,它指的是将学生的实际应答情况进行分类标识。这是量化学生学业成就的关键性步骤,但这个量化结果不能直接计入总分,还需要利用IRT计量模型进行非线性转化。不管怎样,编码步骤是学生实际应答表现向最终成绩量化形成的关键步骤。在仅仅表示对或错的前提下,如何体现学生得到其现有结果的过程是编码的关键,特别对于开放性回答题更是如此。在TIMSS数学测评中,开放性回答题分为短回答题和拓展回答题,其主要区别在于回答过程中的说理时间,或完成整个回答所需的时间。对于开放性回答题的学生表现编码,不仅要体现出对和错的简单判断,还要体现出对于回答过程的判断。为此,TIMSS团队1994年成立了开放性回答题编码量规的开发管理机构:开放性回答题编码委员会。

在开放性回答题的编码系统开发上,泰勒(A.Taylor)的工作起到奠基式的作用。针对测评对题型的新要求,他最早提出了开放性回答题的设计思想,以及对相关编码的思考。[17]他提出了从“正确程度”“方法”“误解或错误类型”三个维度构建编码量规。在这基础上,挪威国家中心在1994年提出使用双位的编码系统,第一位数字表示学生答题正确情况,第二位数字与学生的答题所用方法策略相关。在开放性回答题编码委员会(Free-Response Item Coding Committee,简称FRICC)的相关工作下,TIMSS形成了如下编码系统。[18]

上述编码中,我们看到,70、71、76、79都是不正确并得0分的类别,其中第二位数字表示的是误解或不正确策略使用的类别。FRICC编码量规的制定不仅注重对于正确回答的编码,而且注重对于学生回答过程中相关策略性信息的获取。上述不同信息类型都力求在参加测试国家中具有普遍性、代表性。同时,编码系统的简洁性,保证了编码的高度可靠性。

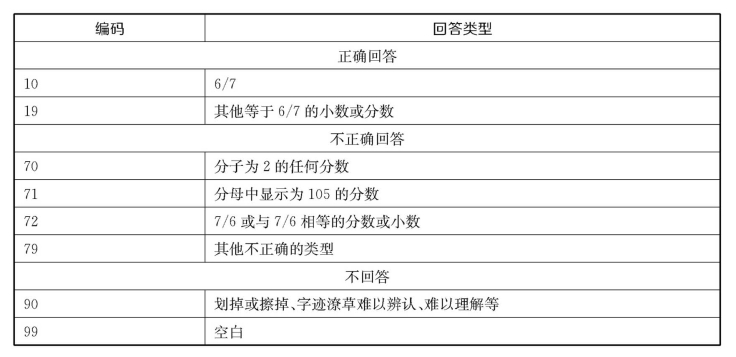

请看以下试题。[19]

计算![]()

该题在内容上考核的是分数和数感,在表现期望上考核的是完成常规过程。具体编码如下。

试题设计围绕TIMSS的框架,同时通过开放性回答题的编码,力求反映学生回答所体现的实际过程,包括方法和策略运用。这为结果解释和分析提供了最直接的依据。

2.1999年的观察维度

该年测评蓝图的试题分布如表4-4所示。

表4-4 1999年TIMSS数学报告类别与题型有关题量交叉表[20]

(续表)

在该年的测评中,题型跟1995年一样,其中选择题题量减少到77%,开放性问题题量在23%左右。在编码系统建设上,设置了0、1、2给分点的拓展性回答题。IRT使用广义的分步计分模型(generalized partial credit),在1999年的编码系统基础上,进一步丰富了二位编码系统。在第一位数值上,“2”表示学生能正确完整地体现过程和结果,体现所要求的清晰完整的解释和相关工作。“1”表示部分正确,包括[21]结果正确,但是过程不正确、没联系或没有任何所需过程,其他不变;②包含了一些正确的过程元素,但是可能不完整或有概念性的瑕庛;③可能结果错误,但是应用了合理的数学过程。

3.2003年的观察维度

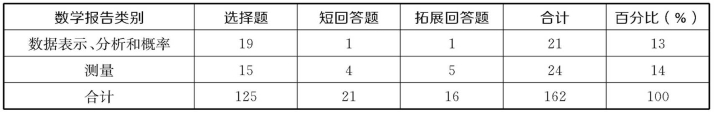

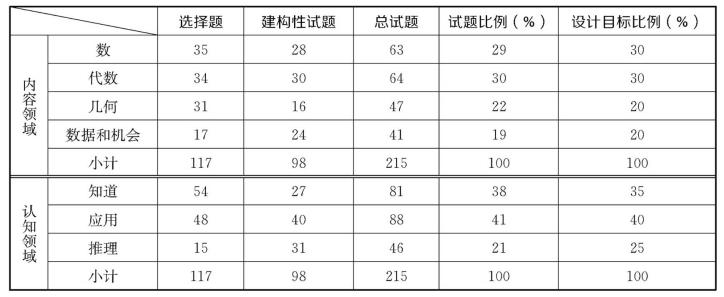

根据相关资料,该年测评蓝图的试题分布如表4-5所示。①

表4-5 2003年TIMSS数学测评蓝图试题分布

按照2007年TIMSS数学测评的框架,2003年的TIMSS数学测评的蓝图如表4-6和表4-7所示。[22]

表4-6 题型与认知领域试题分布交叉表

表4-7 内容领域和认知领域试题分布交叉表

2003年,TIMSS将原有的开放性回答题改名为建构性试题,目的是为了展示学生在该类试题上的解决过程,甚至是非常常规的解决过程。建构性试题还是分短回答题和拓展性回答题。建构性试题和选择题数量的比例约为1∶2。 2003年的TIMSS数学测评,进一步开发了相关建构性或开放性回答题的多级编码,从“0”“1”“2”三级编码拓展到“0”“1”“2”“3”四级编码,这有助于更详细地收集学生回答开放性回答题的过程性信息。整个编码呈现,特别是开放性回答题的编码呈现,基本延续了1995年的特征。虽然知识编码系统多了一层,但在编码上依旧体现了关注学生在试题表现上所体现的类型特征,不在乎学生写得好或不好,更在乎学生在所要测评的相关主题上的学业表现。

4.2007年的观察维度

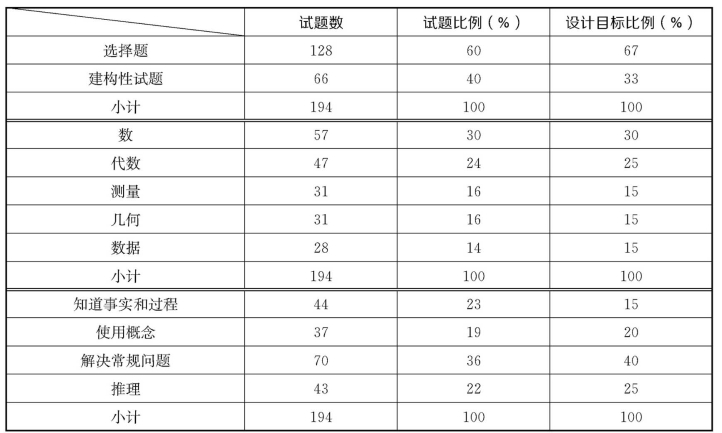

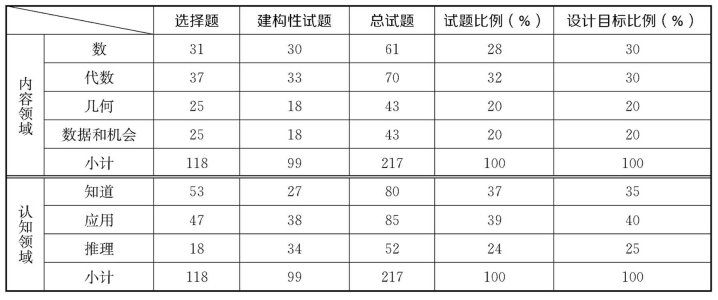

该年测评蓝图的试题分布如表4-8所示。[23]

表4-8 2007年TIMSS数学测评蓝图试题分布

这里的建构性试题和以往的开放性回答题是同一类题型,类似国内中考数学测评的问答题,需要学生呈现解答的过程,甚至问题解决过程中所使用的方法和策略不一定是常规的、熟悉的。该年的建构性试题比例上升,且明显侧重于应用和推理两个认知维度。相比2003年,在推理维度上的权重加大了,同时适当减少了在知道维度上的权重。

5.2011年的观察维度

该年测评蓝图的试题分布如表4-9所示。[24]

表4-9 2011年TIMSS数学测评蓝图试题分布

2011年的TIMSS数学测评在题型、题量及相应内容、认知领域不同维度上的分布,都与2007年类似,只是适当调整了推理部分的试题量,更接近原有的设计目标。同时继续保持建构性试题与选择题在数量上接近1∶1的比例。

TIMSS数学测评在题型使用上,突破了FIMS和SIMS仅仅使用选择题的模式,增加了展现学生回答过程的建构性试题,并逐步增加相应比重。同时,开发了相应的编码系统,保证最大化地获取学生的回答信息。随着目标分析框架中不同维度的调整,在内容领域和认知领域不同维度上的试题比例也作出了相应的变动,但变动幅度不大。

(三)解释维度

整个TIMSS数学测评报告,既有对学生数学整体和数学内容不同维度上精熟度量尺的建立和呈现,又有对不同精熟度层次(TIMSS数学测评中又称基准)的呈现。更进一步,通过历年的研究,在2007年的数学测评报告中建立和呈现了认知方面不同维度上的精熟度量尺。这些结果为详细呈现和阐述测评目标提供了有力的解释方法和依据,同时又有助于进一步多层次、多侧面地反映学生数学学习和教学的实际情况。在解释维度上,则分别对学生精熟度和结果呈现两个方面进行了梳理和描述。

1.学生精熟度分析

(1) 1995年的精熟度分析

TIMSS数学测评通过蓝图中6个内容报告类别,建立了精熟度估计。使用的方法就是利用IRT,整合学生在不同试题上的表现,并根据上述内容报告的类别建立量化量尺(在PISA测评中命名为精熟度)。该精熟度与IRT中所获得的拟真值(plausible values,最早由测量专家梅西克提出)[25]相对应,建立起学生群体相关特质的量化分布,如不同内容维度或能力上的分布,也将学生的实际表现特征与他们在数学上的学业成绩联系起来。

TIMSS数学测评根据上述所得到的精熟度量尺,划分不同的层次。按照参加测试群体精熟度由高到低,取“10%”(标识为P90)、“25%”(标识为P75)、“50%”(标识为P50)三个人群的精熟度数值作为分界点。

在获得相关精熟度量尺的同时,TIMSS还获取了“平均正确比例”(average proportion correct technology)指标。将此指标交给TIMSS课程委员会进行分析,有利于让实际测评内容尽可能覆盖各个国家的数学课程内容,以掌握各个国家在测评内容上的实际表现情况。TIMSS首先获取每个参加测试国家学生在数学内容领域中所有试题的得分率,再取平均,来得到该指标,用于衡量所有参加国家在6个不同内容领域上的表现。值得注意的是,在1995年的TIMSS数学测评中,该指标针对6个内容报告类别(即分数和数感,几何,代数,数据表示、分析和概率,测量,比例),分别对7年级和8年级学生进行了统计。

从学生精熟度分析上来看,TIMSS数学测评在保证获取学生数学学业成就的精熟度量尺,即学生在数学学业多维度上的量化描述之外,还自始至终关注测评内容对于各国数学课程内容的覆盖面,以此保证将课程作为学生学业成就影响因素时,进行相关信息分析的可靠性和有效性。

我们也要看到,在TIMSS数学测评的试题设计和学生表现之间,仅仅通过IRT模型应用,体现出从学生在试题上的实际表现到学生精熟度水平这一单向过程,而没有相关资料说明学生在精熟度量尺上的定位能代表或对应学生数学学业成就表现的某些特征。可以看出,结果解释和试题实际表征两者之间的互通性或对应性并不是很紧密。

(2) 1999、2003年的精熟度分析

延续1995年的做法,TIMSS-R针对数学内容的5个类别建立了精熟度量尺,相比1995年少了“比例”这个内容维度。实际上,1995年的蓝图显示,比例的内容有重叠,所以1999年的进一步合并是合理的。

1999、2003年,TIMSS团队在结果解释和试题实际表征之间做了进一步工作,对所得数学精熟度数据,将学生由高到低排列,以人群所占比例“10%”“25%”“50%” “75%”作为数学精熟度分界点,又称基准点或锚点(anchor point)。最终获取了四类群体(不含75%以下的群体),其中“75%”体现了基础知识和基本技能的要求,如同一条合格线。通过获取量化层面的基准,政策制定者、教育人员和公众都能更好地了解学生在数学上的学业表现。这就需要进一步获取不同基准(或量化指标)上不同学生在数学知识和技能上的表现(或定性表述)。

为了获取在这些基准上学生所能达到的数学知识和技能的实际表现情况,也为了明确不同表现水平(这里指的是数学精熟度量尺根据基准点划分所形成的水平层次)上学生所需掌握数学知识和技能要求的定性表述,TIMSS团队开发了量尺锚固(scale anchoring)方法。这个方法的实际开发使用是在1995年TIMSS数学测评结果的相关分析中,但正式公开是在2000年的出版物中,在1999年数学测评结果分析解释中正式呈现。[26]该方法简单表述就是:首先,研究人员归总在这些锚点附近学生能回答正确(以一定的统计概率意义)的试题,通过分析每道试题在内容和认知上的特征,形成相关试题描述,即获取并提供在不同基准上精熟度与学生在数学知识和技能上所知和所能之间对应关系的描述。

这个量尺锚固的方法,是将学生在试题上的实际应答情况与学生在不同基准之间的联系进行描述的一种方法,也是试题表现观察与结果解释之间的连接点。因此,有必要进一步详细说明,从而有助于分析TIMSS数学测评“观察”和结果“解释”之间的联系,以及其中量化技术的合理使用。

第一步,确定基准点或锚点(它也是数学精熟度量尺上的某一点或数值),然后在每个锚点上加减5,获取锚点所在范围。

第二步,确定定锚标准并选择试题,即在上述所得范围内容中,确定选择观察试题的标准,并选择试题。在1999年的TIMSS数学测评中,所定标准是:首先,对数学精熟度量尺在某锚点所在范围内的学生,至少65%以上(即三分之二以上)能答对这些试题;其次,对于数学精熟度量尺在相邻低一级的某锚点所在范围内的学生,最多50%能答对。如对于“50%”“75%”两个相邻的数学精熟度基准或锚点,数值分别为479、396,则分别确定锚点范围为(474,484)、(391,401)。然后,对于数学精熟度在(474,484)的学生群体,将答对人数所占比例达到或超过65%的试题挑选出来;对于数学精熟度在(391,401)的学生群体,将最多50%的人能正确回答的试题挑选出来。

第三步,数学方面的专家根据上述所得不同锚点范围内符合标准的试题,将测评的五个内容领域(分数和数感,数据表示、分析和概率,代数,几何,测量)上的分布表示出来。

第四步,对TIMSS数学课程框架及测试方面有着丰富经验的专家,逐层分内容审视相应试题,并对不同锚点范围内学生的表现进行描述。首先,要求专家对所选出的试题在内容和认知层面进行简短描述;其次,考虑到试题所在的锚点范围,熟知试题选择的标准,对在每道试题上学生呈现出所掌握的数学知识及认知层面进行描述;最后,在不同锚点范围内,选择相关试题及学生的表现,体现或佐证上述描述。当然,这个过程有反复,最后经集体审议通过,将其纳入相应的TIMSS报告中。通过对不同锚点范围内学生在试题上的表现进行描述,也获得了不同基准上学生实际表现情况的信息。

从上述实际操作过程来看,不同基准上学生的实际表现,反映的是每个基准底端学生在局部试题上的表现,体现了不同基准之间的差异性。同时,试题选择的标准是建立在学生群体对于试题回答正确的比例上,使得试题的选择直接依赖于学生群体。这种试题选择虽然有助于凸显学生在数学不同基准上的差异性,但是也具有不确定性。从统计意义上看,容易使时间纵向基准比较结果的有效性受到质疑。由于基准的体现是由高到低,理论上来讲,基准表现之间应该具有包含性和层级性。那么,不同基准之间学生表现的包含性和层级性如何体现?在上述操作中,我们也注意到,基准的表现与试题所对应的内容直接相联系,但我们知道问题的解决不仅要有内容相联系,更多的是问题解决策略的选择或使用,必须关注认知过程在基准描述中的体现。这些问题伴随着量尺锚固方法的使用而产生。

1999、2003年的TIMSS数学测评对不同基准的群体在测评内容及表现期望等方面的特征进行了分析,并对具体的试题在不同基准群体中的实际表现进行了分析。[27]这既有助于改善学生数学精熟度对学生实际表现的有效反映(在上述1995年结果解释中曾提到),也为各国在不同基准上的表现比较提供了可参照的依据。

考虑到大规模测评比较的目的,研究各国教育系统中影响学生数学学业成就的相关因素时,需要提供更为具体的人群分类基准,这有助于提高研究的针对性。

(3) 2007、2011年的精熟度分析

这两轮的TIMSS测评延续了2003年建立的数学学业成就的精熟度量尺,并在此基础上建立了相应的基准,对不同基准上的学生表现进行分析。这两轮测评针对不同内容领域的维度建立了精熟度量尺。2007年,TIMSS首次在认知领域不同维度上对知道、应用、推理分别建立了量尺,进一步解释了学生在解决问题过程中相应的技能及能力情况,2011年与2007年一样。

2.测评结果的呈现

TIMSS数学测评的目的不仅在于比较各国适龄学生在数学学业的成就,还要从教育系统的角度去分析、研究影响数学学业成就的相关因素。1995年及以后的TIMSS测评获得了如下结果指标。

·数学内容的相关学业成就指标(即精熟度量尺),数学认知层面的相关学业成就指标(2007年设计开发),数学内容基准及相关描述(1999年设计开发)。

·跟学生学业成就相关的背景指标。除了课程这个始终贯穿于TIMSS研究中心的相关因素外,TIMSS还分别从学生、教师、学校三个角度分析了相关影响因素,并通过三类相应问卷获取相关指标。学生问卷在收集学生个人信息的同时,还关注学生在学习数学上的相关家庭信息,如学生对数学的态度、父母的期望及校外的活动。教师问卷主要收集教师本身信息,如训练时间、经验及在校时间等,还有课堂教学实践相关指标。学校问卷主要收集有关组织和资源方面的相关指标。

自2003年开始,研究团队充分利用1995年和1999年的相关数据,使TIMSS数学测评对不同国家的数学精熟度量尺、相关内容领域的精熟度量尺和不同基准上的表现及排名进行了详细的图表描述,体现了不同国家在数学学业上的不同趋势情况。同时,历年的TIMSS数学测评坚持利用背景指标与学生的学业成就指标之间的联系进行分析,这既是由于IEA前期的工作积累,如FIMS和SIMS的影响因素分析,也在很大程度上得益于沙伍森及他的同事研究教与学的关系并构建相关指标的工作,该工作尝试利用IPO模型建立起学习结果影响模型,如图4-6所示。

图4-6 IPO学习结果影响模型[28]

总之,在结果解释分析维度上,TIMSS数学测评体现了从建立内容量尺到建立认知量尺的发展过程。基准的建立和描述弥补了测评初始对于学生在不同层次水平上表现描述的不足。

这里小结一下历年TIMSS数学测评在认知、观察和解释维度上的表现。无论是1995年的第三次国际数学和科学研究,1999年的TIMSS-R,还是2003年以来的国际数学和科学趋势研究,TIMSS始终保持着原有的研究初衷,即首先了解各个参加测评国家在数学学业成就上的表现情况,然后进一步了解学生数学学业成就的影响因素及其存在的差异,最后通过该测评更多地获取有关数学课程、教学实践与高水平学生学业成就之间的相关信息,不断改善全球数学的教与学。多轮测评信息数据的积累,在时间纵轴上为参加测试的国家呈现了一个变化的图景,为各个国家学生学业成就的发展趋势研究提供了进一步的思考。

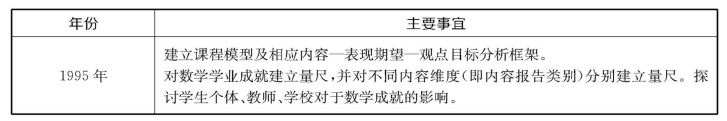

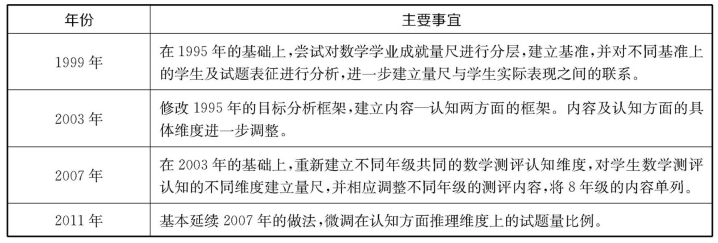

在根本目标没有发生变化的情况下,从1995年至2011年,五轮的数学测评(这里着重指群体2或8年级)在各年度的变化内容,简要归纳如表4-10所示。

表4-10 TIMSS数学测评五轮变化内容

(续表)

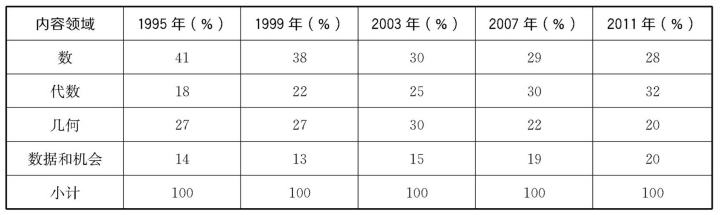

由于TIMSS数学测评将课程作为影响学生数学学业成就的主要因素,同时为了最大可能地覆盖不同参加测试国家的数学课程内容,研究团队通过分析课程文本等方法来确定数学测评的内容。这里的内容比例变化值得关注。我们以2007年的测试内容作为分类标准,将1995年的报告类别“比例”及“分数和数感”合并成“数”,将1995年至2003年的“测量”及“几何”合并成“几何”,那么1995年至2011年,TIMSS数学测评在“数”“代数”“几何”“数据和机会”上的试题题量比例如表4-11所示。

表4-11 TIMSS数学测评五轮题量比例分布

2003年测评内容的覆盖及相应的比例调整,主要是通过重新分析、调查历年TIMSS数学测评和近十年来各国数学课程的变化而获得的,这是一个很大的变化。从表4-11中我们看到,在试题题量上,“数”所占的比例逐步降低,“代数”所占的比例逐步上升,但是两者之和所占的比例基本控制在60%。同时,从2007年和2011年的设计比例看,“数”和“代数”的所占比例各保持在30%左右,“几何”和“数据和机会”的所占比例各保持在20%左右。

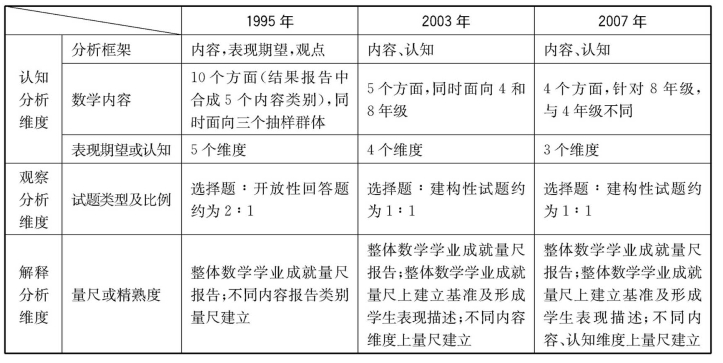

从历年TIMSS的总体发展变化来看,1995年、2003年和2007年是TIMSS发展变化比较明显的三年,1999年与1995年类似,2011年与2007年类似。为了进一步细化相关变化,表4-12罗列了TIMSS数学测评发展在不同分析维度上的表现。

表4-12 TIMSS数学测评发展在不同分析维度上的表现

从表4-12可以看到,无论是内容维度的数量,还是表现期望或认知维度的数量,都在逐步减少。在逐步增加开放性回答题或建构性试题的题量比重和建立学业精熟度量尺的同时,在种类上和所体现的层次(TIMSS称为基准)上都有明显的增加。整个TIMSS数学测评发展过程体现出如下特点。

·在目标分析框架内容或认知领域设计上,越来越注重体现试题在内容、内在上的联系性,尽量不去将内容领域和认知领域划分得很细,导致人为碎片化。从TIMSS数学测评框架的发展来看,在内容主题或不同认知维度上体现出逐步整合的趋势。特别在内容不同维度的构建上,随着测评时间的增加,不仅关注各国数学课程的相应变化,还注意体现各国数学课程的不同内容分布及权重。为了便于试题在内容上体现出一定的联系性,TIMSS测评在内容主题方面不断进行整合,最终形成数、代数、几何、数据和机会四个内容维度。在表现期望或认知领域上,着重对试题所引起的行为特征进行归类和描述。虽然淡化了布卢姆认知分类目标的层级性,但是不可否认,在认知的不同维度上的行为描述还是深受其影响,这在2011年认知领域的描述中尤为明显,层级性跃然纸上。值得注意的是,在TIMSS数学测评认知领域发展后期,注意到从问题解决的角度去考虑,但是它更多考虑的是问题解决的类别,而不是问题解决的过程。

·系统的完整性。这里要指出,精熟度量尺的建立使得测评系统的结果与目标相呼应,有助于体现出系统内部的一致性。首先,要提到的是IRT及其技术在整合学生试题表现上的作用(这里主要是以数值形式呈现的编码)。其次,精熟度量尺作为整个测评系统的结果之一,也是对原有目标的量化解释。1995年到2007年,在测评系统框架所构建的内容和认知两个方面,如何建立相应的量尺来体现不同国家及学生数学学业成就的可比较性,是几轮工作的重心。同时值得注意的是,相应的维度量尺,如内容上不同维度量尺的建立,反过来又影响了下一轮内容维度的构成,如1999年的内容报告类别为2003年的内容维度构建奠定了基础并提供了参考依据。

·统计模型的使用及编码系统的构建。无论是内容或认知的不同维度,还是学生在不同类别试题上的表现,都要经过两道程序。首先是编码,其次是通过统计模型,如通过对IRT技术进行整合,得到学生在不同维度量尺上的数值。随着试题从单一选择题走向选择题与建构性试题(或开放性回答题)的结合,解题过程愈发体现出数学思维或策略使用的复杂性和多样性。形成有效可靠的编码系统是整个测评工作的重中之重,也是难点所在。从简单显示对错到判别“0”“1”,到形成双位的编码系统;从双位编码系统中第一位仅体现对错,到体现全对、部分对、错的多级评分——这些体现了获取学生回答信息情况的不断细化的过程。特别是对全对和部分对的学生答题案例进行归类和分析,为学生在不同维度量表上的数值所对应的答题描述提供了直接证据。

针对上述编码为一级的选择题和短回答题,TIMSS团队分别选择了IRT三参数模型和双参数模型。这里的区别在于选择题选择项的可猜测性,这个可猜测性需用一个单独的参数来体现。对于拓展性回答题,其编码往往呈现多级,就像应用IRT的多步计分模型,可以说这些模型与题型的特点充分匹配。

如果说上述编码系统的构建为学生实际应答表现特征和量化之间建立了一个联系,那么统计模型的使用则进一步在学生的实际应答表现特征与考核目标维度之间建立了一种内在的联系。

上述这种学生在试题上的实际表现与精熟度量尺数值(或区间)之间的联系,还集中体现在TIMSS数学测评整体数学精熟度基准的划分和描述上。具体如1999年TIMSS数学测评解释中所提到的,在利用量尺锚固的方法上存在着以下不足。不足一,该方法仅仅反映了每个基准底端学生在局部试题上的表现,力求体现的是不同基准之间的差异性。试题选择的标准建立在学生群体对于试题回答正确的比例上,使得试题的选择直接依赖于学生群体。这种试题选择虽然有助于凸显当年测评学生在数学不同基准上的差异性,但是这种选择试题的不确定性,容易使得在时间纵向上的基准比较结果的有效性在统计意义上招来质疑。不足二,由于基准的体现是由高到低,理论上基准表现之间应该具有包含性和层级性,但是不同基准之间学生表现的包含性和层级性恐很难顾及。不足三,从具体方法的操作中,可注意到基准的表现与试题所对应的内容直接相联系,但问题的解决更多涉及问题解决策略的选择或使用,必须关注认知过程在基准描述上的体现。但是认知过程是一个连续体,在不同基准之间体现的层级性和连续性更难处理。

无论怎样,整个TIMSS数学测评的目标,在设计和操作过程中试题内容的分布及题型的整合,还有相应精熟度量尺的逐步开发,都越来越体现出整个测评系统的完整性,测评系统的框架也越来越清晰化。这也为参加测评的各个国家提供了更加可靠、有效的相关信息或指标,为认识和改善其教育政策提供了依据和参考。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。