第三节 实证研究的基本技术

一、相关关系和相关分析

相关关系,是指研究现象之间确实存在的,但关系数值不确定的相互依存关系。它与一般的函数关系不同,函数关系是变量间确定的一种依存关系;相关关系对于一个变量的数值,另一变量可能会有数个甚至许多个数值。相关关系包括因果关系,还包括两个变量受第三个变量或其他变量的影响而发生的共变关系。

相关关系有以下一些分类方式:(1)单相关和复相关。前者也称一元相关,它是指两个变量的相关关系;后者也称多元相关,它是指一个因变量与多个自变量之间的相关关系。(2)线性相关和非线性相关。前者是指一个变量增减一个单位,另一相关变量按一个大致固定的增(减)量变化的相关关系,后者是指一个变量增减一个单位,另一相关变量不按一个大致固定的增(减)量进行变化的相关关系。(3)正相关和负相关。前者是指相关变量按同一方向变化的相关关系;后者是指相关变量按相反方向变化的相关关系。(4)完全相关、不完全相关和不相关。完全相关是指变量之间依存关系几乎完全接近于函数关系的相关关系;不相关,也称零相关,是指变量之间几乎不存在依存关系的相关关系;不完全相关是指介于完全相关与不完全相关之间的相关关系。

相关分析是指对变量之间的相关关系的分析。它研究变量之间的共变关系,这些变量相互对应,却不分主从和因果,主要测定变量之间的密切程度和变量变化的方向。

二、回归分析和一元线性回归分析

回归分析,是指对具有相互联系的客观事物或现象,根据其关系形式,选择合适数学模式,以近似描述变量间变动关系,测定它们的密切程度,揭示其变化的具体形式和规律性的一种分析方法。它由英国遗传学家高尔登(Francis Galton)首创,最初用于对血缘关系的研究,后来在自然科学、工程技术、政策评价和社会经济领域都得到广泛应用。尤其在计量经济研究中,相关和回归的分析方法已成为构造各种经济数学模型,进行结构分析、政策评价、预测和控制的重要工具。

回归分析研究两个或两个以上变量间的关系形式,不论研究变量有多少,应择其中之一作为因变量,其余当作自变量。回归预测是指根据现象数量变化关系,建立回归方程进行的一种预测。它可通过对两个或两个以上变量从过去到目前的观察值进行回归分析,建立直线回归方程式或曲线回归方程式;然后将与预测因变量有关的自变量代入回归预测方程,即可得到因变量的预测值。例如,研究一个因变量与一个自变量的因果关系 =a+bx,称为一元线性回归分析。x为自变量,

=a+bx,称为一元线性回归分析。x为自变量, 是因变量y的预测值,也称理论值;a是回归直线的截距,b为回归直线的斜率(即回归系数)。假定有n个数据,应用最小二乘法,可求得a和b值并确定直线回归方程模式。其中:a=(∑y-b∑x)/n;b=[n∑xy-∑x∑y]/[n∑x2-(∑x)2]。根据回归方程式,在有效的相关区间内,可由x取值来预测

是因变量y的预测值,也称理论值;a是回归直线的截距,b为回归直线的斜率(即回归系数)。假定有n个数据,应用最小二乘法,可求得a和b值并确定直线回归方程模式。其中:a=(∑y-b∑x)/n;b=[n∑xy-∑x∑y]/[n∑x2-(∑x)2]。根据回归方程式,在有效的相关区间内,可由x取值来预测 值。

值。

回归分析是对事物或现象的相互依存关系的分析,只有存在相互关系的变量才能进行回归分析。因此,在回归分析前应先进行变量之间的相关分析。例如,在一元线性回归分析时,应通过计算相关系数ρ(或r)来判断变量之间的相关程度。一元回归模型Y ∧

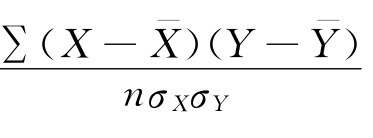

=a+bx,式中:x为自变量; 是因变量y的预测值,也称理论值。相关系数ρ=r=

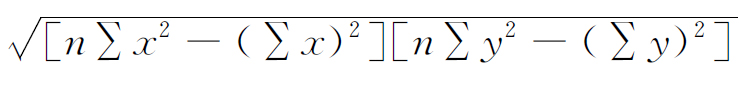

是因变量y的预测值,也称理论值。相关系数ρ=r= =(n∑xy-∑x∑y)/

=(n∑xy-∑x∑y)/ 。r的取值范围在-1和+1之间,r=1,表示完全正相关;r=0,表示不相关;r=-1,表示完全负相关。一般认为,0<|r|≤0.3,表示微弱相关;0.3<|r|≤0.5,表示低度相关;0.5<|r|≤0.8,表示显著相关;0.8<|r|≤1,表示高度相关。

。r的取值范围在-1和+1之间,r=1,表示完全正相关;r=0,表示不相关;r=-1,表示完全负相关。一般认为,0<|r|≤0.3,表示微弱相关;0.3<|r|≤0.5,表示低度相关;0.5<|r|≤0.8,表示显著相关;0.8<|r|≤1,表示高度相关。

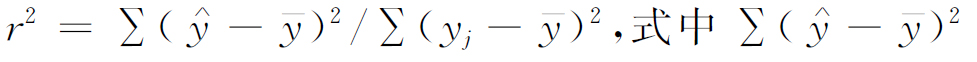

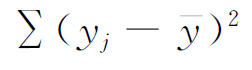

r2是判定系数,其算式为 为回归偏差;

为回归偏差; 为总偏差。r2是判定回归直线拟合优度的一个重要指标,拟合优度是指点分布在回归直线两侧的紧密程度,它关系到回归模型的应用价值。一般来说,r2在0~1之间。r2与r具有一致性,一元线性回归的r2的平方根,就是简单线性相关的相关系数r。相关分析与回归分析密切联系,变量之间相关程度愈大,回归分析结果愈准确。

为总偏差。r2是判定回归直线拟合优度的一个重要指标,拟合优度是指点分布在回归直线两侧的紧密程度,它关系到回归模型的应用价值。一般来说,r2在0~1之间。r2与r具有一致性,一元线性回归的r2的平方根,就是简单线性相关的相关系数r。相关分析与回归分析密切联系,变量之间相关程度愈大,回归分析结果愈准确。

三、多元线性回归分析和非线性回归分析

研究一个因变量与多个自变量的线性相关关系,称为多元线性回归分析,其回归方程的一般模式为:y∧=a+b1x1+b2x2+…+bnxn。二元或其他多元回归模型的基本性质与一元线性回归模型相同,因此多元线性回归分析的原理与方法同一元线性回归分析基本相似。但是,多元线性回归分析的变量比一元线性回归分析的变量多,因此计算较复杂。在多元线性回归中,可采用最小二乘法进行一次回归分析,也可在所研究的全部因素中按其与y相关程度的大小,逐个把自变量引入或剔除,进行逐步回归分析。

在多元线性回归分析中,对自变量之间是否存在相关关系也应进行分析。如果各自变量间存在相关程度很高的情况,这在统计上称为多重共线性。在多重共线性下,各自变量对因变量的影响无法区分,各自变量对因变量的净影响也就无法正确预测。因此,在这种情况下应设法消除多重共线性的影响。

现实经济活动中,呈“直线”状态的线性函数所反映的经济关系是较少见的。事实上,在许多实际问题中因变量与自变量的关系不是线性的,而是处于非线性的曲线状态的,如双曲线、指数曲线、S形曲线等。如果因变量与自变量关系是非线性的,这时须要拟合适合类型的曲线模型,这种回归问题的分析称非线性回归分析。分析时,可根据经验、理论分析、散布点图等方法来拟合适当的曲线。非线性回归也可分为一元非线性回归和多元线性回归。统计上往往可采用变量代替的方法,把非线性状态的问题转化为线性状态的问题来解决。于是,线性回归的分析方法也可应用于非线性回归问题的分析研究。

四、高级统计技术

对于变量X和Y来说,数学期望EX、EY反映了X、Y各自的平均取值,方差DX、DY反映了X、Y各自偏离均值的离散程度,它们反映了X和Y各自的数字特征。而协方差Cov(X,Y)则反映了X和Y之间的相互联系。

方差分析,是检验两组或多组样本均数之间是否具有统计意义上的显著差异的一种统计方法。例如,对于不同行业、不同股权结构、不同所有制企业,研究它们财务状况(资产负债率)和财务成果(主营业务利润率与净资产报酬率)等方面是否具有明显差异,这就可进行方差分析。

(二)判别分析

聚类分析与判别分析是判别分类的两大基本方法。在分析中,往往会遇到根据观察到的数据来对研究对象进行判别分类的问题。如研究企业规模时要对企业是属于大型,还是中小型进行判别分类;在环境科学研究中,要对地区的环境情况是属于严重污染、一般污染还是无污染作出判别等。所谓判别分析(Discriminant Analysis),就是根据对某种事物现有类别的认识,来对新事物的类别进行判别的分析方法。它要解决的问题是在已知历史上用某些方法已把研究对象分成若干组的情况下,再来判定新的观察样本应归属的组别。

其基本方法是,先根据已知所属组的样本给出判别函数,并制定判别规则;再依此判别每一个新样品应归属哪一组。常用的判别方法有距离判别、贝叶斯判别和费希尔判别等。判别分析时难免会出现误判,误判概率一般需要通过样本来作出估计。在各组不能假定为正态的情况下,估计判误概率的方法通常有三种,常用的是交叉验证法或称刀切法。

(三)聚类分析

“物以类聚,人以群分”,把相似事物归为一类,分析和解决问题就会更加方便。聚类分析(Cluster Analysis)其目的就是要将分类对象按一定规则分成若干类,这些类不是事先给定的,而是根据数据特征确定的,对类的数目和类的结构不必作出任何假定。

聚类分析与判别分析的区别在于:判别分析需要对类有事先了解,它是根据现有某类别的认识,再对新样本的归属进行判别。如果无现有某类别的认识,则对类的事先认识和断定往往可用聚类分析的方法来解决。聚类分析根据分类对象不同可以分为Q型和R型聚类分析。测量变量的尺度通常有间隔尺度、有序尺度和名义尺度三种,间隔尺度使用最多。距离和相似系数反映了样本的相似程度,相似程度越高,两个样品(或变量)的距离越小或相似系数(或其绝对值)就越大;反之则反是。

系统聚类法是最常用的一种聚类方法,常用的系统聚类法有最短距离法、最长距离法、中间距离法、类平均法、重心法、离差平方和法、可变法和可变类平均法等,须视情况应用。在许多应用中,类平均法和离差平方和法的聚类效果较好。

(四)主成分分析

主成分分析,或称主分量分析(Principal Component Analysis),是通过降维把过多的变量简化为数个“主成分”(综合变量)以利于统计分析的一种方法。这些“主成分”能反映多变量所含有的绝大部分原始信息。一般只要变量之间存在一定的相关性,前几个主成分往往能具有较高的累计贡献率,于是采用降维技术就可达到减少维数的目的。主成分分析的目的有二:一是过多变量的降维,二是主成分的解释。分析中,难以对所取主成分的数量定出一个“正确”标准。在取得明显降维的情况下,主成分的累计贡献率越高,效果越好。但是,所取(前几个)主成分的累计贡献率至少应多大,也是很难确定的。

在主成分分析中,这些主成分往往表示为原始变量的某种线性组合,第一主成分所包含的信息量最大,第二主成分其次,其他主成分依此类推。每个主成分之间互不相关,从而保证各主成分所含信息互不重复。成功的主成分分析应该是:在达到维数明显减少的情况下取得的主成分能依旧保留原始变量的绝大部分信息,以及能给出主成分的符合实际背景和意义的解释。解释主成分时,先应考察主成分的原始变量上的载荷,再应考察主成分与原始变量的相互关系。这种解释也是主成分分析的难处之一。

(五)因子分析

因子分析(Factor Analysis)起源于20世纪初,它是由K·皮尔逊(Pearson)和C·斯皮尔曼(Spearman)等为定义和测定智力而作出的一种统计分析。它是主成分分析的推广,也是一种降维技术,其目的是用少数不可观察的隐变量来解释大量原始变量间的相关关系。在形式上,因子模型与线性回归模型相似,但两者存在本质区别,两者的参数意义不相同,后者自变量是可观察到的,而前者的各公共因子是不可观察的隐变量。

因子分析通常采用以下四个基本分析步骤:(1)确认原始变量是否适合因子分析;在因子分析前,一般须要对原有变量进行相关分析。最简单的方法是计算变量间的相关系数矩阵并进行统计检验。如果相关系数矩阵中的大部分相关系数都很小且未通过统计检验,那这些变量就不适合作因子分析。(2)提取因子变量;提取因子的方法很多,有主成分法(Principal Component)、最大似然法(Maximum Likelihood)、映象因子提取法(Image Factoring)、艾尔法因子提取法(Alpha Factoring)和不加权最小平方法(Unweighted Least Square)等。其中以主成分法最为常用。(3)利用旋转方法使因子变量更具可解释性;因子分析的目的在于对原始变量进行分门别类的综合评价,为此须要给因子赋予具有实际意义的解释。当获得的因子及其载荷矩阵难以与实际问题相对应时,可以通过因子旋转使旋转后的因子更具有实际意义。最常用的旋转方法是最大方差旋转法(Varimax)。(4)计算因子得分。因子得分就是各因子变量的最终体现。有了因子得分,此后的分析研究就可不再针对原有指标变量,而是简化为对样本各因子得分变量的研究,从而达到降维的目的。比较常用的因子得分估计方法有加权最小二乘法(Bart-lett法)、回归法和安德森-鲁宾(Anderson-Rubin)法。在一定的假设下可以证明:从条件意义上来说,加权最小二乘法的因子得分也称巴特莱特(Bartlett)因子得分,是无偏的。

必须指出,因子分析的基本目的在于可使用少量因子来描述众多指标或因素之间的联系,即将相关又较密切的多个变量归为一类,每一类变量成为一个因子。称其为因子,是因为它是不可观测的,不是具体的变量。因子分析可使用旋转技术帮助解释因子,这样在解释方面便更具有优势。于是,因子分析就能以少量因子来反映众多指标中大部分的主要信息。因此,这种分析方法可浓缩信息、降低指标维度、简化指标结构,并在尽可能减少主要信息损失的前提下避免变量间的共线性问题,从而使指标体系分析更加简单有效。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。