“网络蜘蛛”可不是自然界中真正的蜘蛛,它所指的是一种叫蜘蛛或网上行者的小软件——搜索引擎。

一个网络软件怎么就被称作“蜘蛛”了呢?别着急,让我们先来了解了解这个小软件。

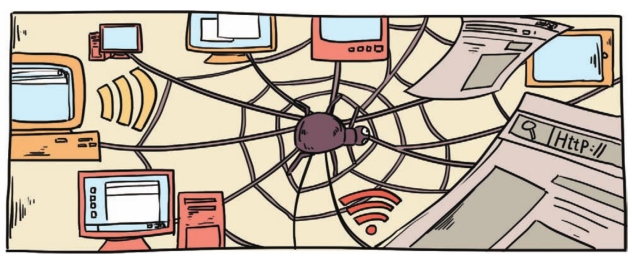

我们都知道,互联网就是个信息的海洋,而且总有无数的信息无时无刻不在涌进涌出。我们想要找到自己所需要的信息资源在哪一个网页上,如果单靠我们一个网页一个网页地去找,估计从少年熬到白发苍苍的老人,变成了“老花眼”也不一定找得到。

这时候,就得用到“网络蜘蛛”——搜索引擎了,有了它的帮忙,可就事半功倍了。

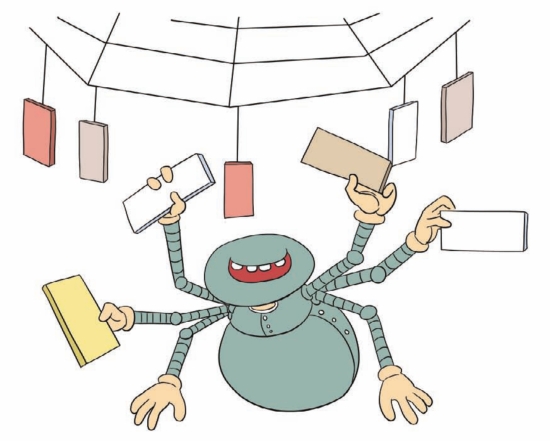

事实上,神奇的“网络蜘蛛”就像电脑“机器人”一样,整天在网络的上百万个网页间来回游走,有事没事就看看这些网页,并记住它们所在的位置,列出一个清单方便用户需要时进行查找。

此外,每天网络上都会新增无数网页,这些“蜘蛛”还得到处爬行收集这些新网页的数据,如此反反复复,不知疲倦。再加上,人们常把互联网比作一张蜘蛛网,这种搜索引擎的小软件也就被看成是在“网”上爬来爬去的“蜘蛛”了。

当我们向“网络蜘蛛”发出要搜索什么内容的指令时,“网络蜘蛛”就会迅速跑到列好的清单上抓取出与我们想要的内容最匹配的网站,并将找到的结果显示在电脑屏幕上。

这时,我们只要点击那些带下划线的语句,就可以看到更详细的内容了。从发出指令到找到资料,仅仅需要几秒钟,速度快得惊人。

那是不是搜索引擎可以把所有相关的网页都搜索出来呢?

呵呵,现在的搜索引擎可还没这么厉害,它们只能抓取互联网上相关的一部分网页而已。

首先,如今的网络信息实在太多,即使搜索引擎能帮你全部找出来,你也未必看得过来;再者,有些网页对自己的数据设置了密码和访问权限,有些还得是会员才能访问。这时候,“网络蜘蛛”提供不出相应的用户名和密码,就只能吃“闭门羹”了。

不过,很显然,“网络蜘蛛”的搜索速度已经把我们人工搜索的速度甩出了十万八千里。

现在,在中国受欢迎的搜索引擎有很多,它们的搜索速度快而且搜索出来的信息多。

但是,现在的网络中垃圾信息太多,要是搜索引擎能变得更智能,可以区分出信息的好坏的话,就能更精准地找到我们想要的信息了。目前,已经有不少公司在往这个方向发展,如Copernic Agent(Copernic的代理)。

你知道吗

搜索引擎的五个组成部分:1.网页抓取系统:网页抓取系统的工作原理是首先搜索引擎派出爬行蜘蛛搜索整个互联网的网页,并沿着网页上的每一个链接继续向下抓取。2.数据分析和处理系统:当蜘蛛抓取的网页下载回来之后,数据分析系统便开始工作了,根据搜索引擎收录的标准对网页进行分析,进而判定哪些网页是可以收录的,哪些网页是需要删除的;当数据分析完成之后,接下来便是数据处理系统开始工作,数据处理系统主要原理就是根据搜索引擎的算法对网站的外链、内容、权重、关键词进行分析,然后对网页进行排序。3.存储系统:数据存储系统里储存的网页是经过处理系统处理过的干净数据,并且根据网页的内容进行了分类。4.缓存系统:一般缓存系统分为临时缓存区和时段缓存区,临时缓存系统主要是针对临时网页的排名,而时段缓存区一般是24小时变动一次。5.展示系统:展示系统中的数据都是被处理好的,包括网页的排名,网页的权重计算等等,只要用户进行搜索,这些数据就可以快速地展现在用户面前,而不需要进行新一轮的抓取、处理、排序等复杂工作。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。