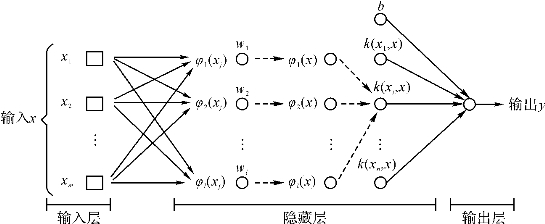

支持向量回归的结构设计由输入层(Input Layer)、隐藏层(Hidden Layer)和输出层(Output Layer)构成,训练集在输入层和隐藏层之间进行非线性转换后,就可以在输出空间上进行线性回归。理论上说,只要隐藏层的维数足够高,那么支持向量回归可以趋近任何一种非线性的映射关系。输入变量和输出变量存在一个未知的映射函数关系g(x),我们通过对训练集进行训练,得到决策函数f(x),近似于g(x),再用f(x)去做预测,式4-8为决策函数的表达形式,图4-3为支持向量回归的结构图。

式中,φ(x)=[φ1(x),…,φl(x)]T为从输入层到隐藏层的非线性转换方程,w=[ω1,…,ωl]T代表从隐藏层到输出层的线性权重,b代表阈值。

图4-3 支持向量回归的结构图

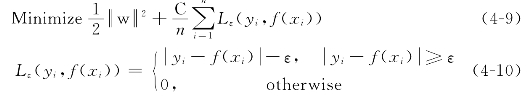

要获得f(x),必须用训练集估计出参数ω和b,参数ω和b可以根据最小化的结构风险函数式4-9估算。

式中, 2/2代表置信风险,也就是分类器在未知文本上分类的结果误差,最小化该项也就是获得最大的泛化预测能力,(1/n

2/2代表置信风险,也就是分类器在未知文本上分类的结果误差,最小化该项也就是获得最大的泛化预测能力,(1/n  Lε(y i,f(x i))代表由ε不敏感方程决定的经验风险,所谓经验风险就是分类器在给定样本上的误差,最小化该结构风险函数反映了SVR的基本理论设计,最小化这两项意味着SVR不仅能够最小化经验风险,而且同时最大化推广能力,最终获得两者间的平衡最优解。ε为线性ε不敏感损失方程中的误差参数,当预测误差小于ε时损失可以被忽略,该类损失方程也是SVR方法所特有,目的是简化样本信息量,这样即使样本维数很高,也不会给计算和存储带来很大麻烦。当松弛变量ξ和ξ'引入结构风险函数后,式4-9变为式4-11,其中松弛变量ξ和ξ'代表了预测误差超过ε时的真正损失,C为惩罚参数,控制对ε带外样本数据的惩罚程度。

Lε(y i,f(x i))代表由ε不敏感方程决定的经验风险,所谓经验风险就是分类器在给定样本上的误差,最小化该结构风险函数反映了SVR的基本理论设计,最小化这两项意味着SVR不仅能够最小化经验风险,而且同时最大化推广能力,最终获得两者间的平衡最优解。ε为线性ε不敏感损失方程中的误差参数,当预测误差小于ε时损失可以被忽略,该类损失方程也是SVR方法所特有,目的是简化样本信息量,这样即使样本维数很高,也不会给计算和存储带来很大麻烦。当松弛变量ξ和ξ'引入结构风险函数后,式4-9变为式4-11,其中松弛变量ξ和ξ'代表了预测误差超过ε时的真正损失,C为惩罚参数,控制对ε带外样本数据的惩罚程度。

该表达式也被称为SVMR的原问题,其中,x i∈R m为m维的投入,即为m个解释变量,y i∈R1为1维产出,也就是被解释变量。把所有的限制条件代入目标函数,我们可以得到原问题的拉格朗日函数式4-15:

式中,拉格朗日乘子满足:ηi≥0, ≥0,αi≥0 ≥0。

≥0。

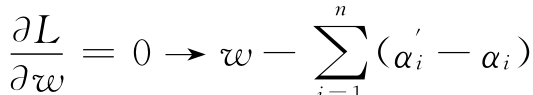

根据Karush-Kuhn-Tucker(1951)最优化条件,L对变量ω,b,ξi的求导函数为零: )φ(x)=0。

)φ(x)=0。

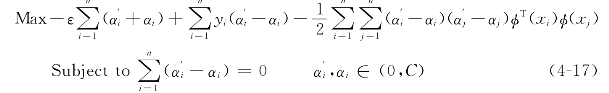

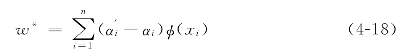

将式4-16代入式4-15,我们就得到了SVR原问题的对偶问题表达式:理论上ω和b应根据SVR的原问题求解,但Scholkopf,Smola(2001)以及邓乃杨,田英杰(2004)都指出SVR原问题的对偶问题比原问题更容易求解。因此,我们可以先解出对偶问题的最优解,再来求得ω和b。从这个对偶问题中我们可以解得拉格朗日乘子 和αi,解出式4-16,我们得到ω的最佳值:

和αi,解出式4-16,我们得到ω的最佳值:

将式4-18代入式4-8,我们得到:

![]()

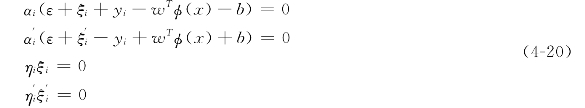

我们可以根据Karush-Kuhn-Tucker互补松弛条件来解出b的最佳值:

解得b的最值值b*:

当解得最佳参数ω*和b*,式4-8有了以下的形式:

在式4-23中, 和

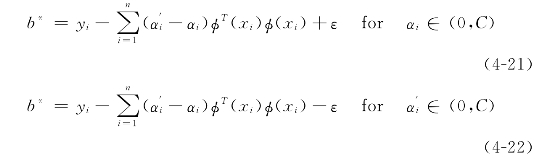

和 已被解出,K(x i,x)被定义为核函数,任何满足Mercer定理(Vapnik,1995)的函数都可被定义为核函数。从以上的证明过程我们可以看到,在最后SVR模型的估算公式中,我们只需要选择核函数的形式就可以了,并不需要隐藏空间非线性转换函数φ(x)的形式和计算它们的内积,这一点,刘广利,杨志明(2002)也给出过解释,常用的核函数有线性核函数、径向基核函数(RBF)、多项式核函数、sigmoid核函数等。核函数的表达式如表4-1所示。

已被解出,K(x i,x)被定义为核函数,任何满足Mercer定理(Vapnik,1995)的函数都可被定义为核函数。从以上的证明过程我们可以看到,在最后SVR模型的估算公式中,我们只需要选择核函数的形式就可以了,并不需要隐藏空间非线性转换函数φ(x)的形式和计算它们的内积,这一点,刘广利,杨志明(2002)也给出过解释,常用的核函数有线性核函数、径向基核函数(RBF)、多项式核函数、sigmoid核函数等。核函数的表达式如表4-1所示。

表4-1 常用核函数表达式

从上述支持向量回归的理论背景和运算过程介绍中我们可以看到支持向量回归有很多优点:比如,SVR不需要知晓模型的形式,也不需要对数据生成过程的分布进行任何设定,且不论样本容量大小,只要对样本不断进行训练,就可以获得样本数据间最优的非线性映射关系用于预测,所以适合先验知识不清楚的应用问题。这点优于传统的基于OLS或MLE的结构模型和时间序列预测模型,这类模型通常采用参数化的线性回归模型,需要满足多种古典假设,而现实中大部分金融数据并不能满足这些假设,回归方程的选择和分布函数的设定可能产生偏差,而且费时、效率低下也降低了传统方法预测的准确性和灵敏度。SVR既能估计大样本,而且也适合于样本容量小的情况,并且,也不需要正态分布等先验假定。但是该方法也存在着不足,支持向量回归方法的难点在于核函数以及参数的选择,这两者的选择至今没有统一公认的方法。在众多核函数中RBF核不仅容易执行,并且可以有效地将训练集非线性地映射到无线空间层中,非常适合处理非线性关系问题(Wei-Chiang Hong,2009)。因此,本书使用软件默认的RBF核。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。