第6章 潜在的问题

6.1 是是非非的量子电动力学

从前文的介绍中已然得知,精细结构常数与量子电动力学密切关联着。那么量子电动力学在精细结构常数的理论计算上为何不能有所作为呢?

通常认为,量子电动力学主要是在以下工作的基础上建立起来的:

M.Born and P.Jordan,Zeitschr.f.Phys.34,858,1925;

M.Born,W.Heisenberg and P.Jordan,Zeitschr.f.Phys.35,557,1925;

P.A.M.Dirac,Proc.Roy.Soc.A 114,243,1927;

P.A.M.Dirac,Proc.Roy.Soc.A 114,710,1927;

P.Jordan and E.Wigner,Zeitschr.f.Phys.47,631,1928;

P.A.M.Dirac,Proc.Roy.Soc.A 117,610,1928;

P.A.M.Dirac,Proc.Roy.Soc.A 118,351,1928;

W.Pauli and W.Heisenberg,Zeitschr.f.Phys.56,1,1929;

W.Pauli and W.Heisenberg,Zeitschr.f.Phys.59,168,1930。

这些工作对于物理学所面临的某些基本问题提出了一些假设。这些假设一方面促进了量子电动力学的发展,但在另一方面,也造就了日后令量子电动力学难以逾越的某些障碍。在量子电动力学所涉及的基本问题中,电子的大小可以说是一个根本性的问题。

电子有大小吗?

自从电子被发现以来,这一直都是个问题。

从众多的实验结果看,电子乃携带着一定质量和电荷的客观实体是一个不争的事实。既然如此,根据通常的经验,凡是客观实体,必定具有一定程度的空间延展性,即拥有明确的几何尺度。因此在二十世纪初,有人就提出了一个经典半径的概念,用re表示:

![]()

不过,想让这一概念发挥作用,还必须解决电子自身的稳定性问题。为此,法国的数学兼物理学家庞加莱引进一种表面张力以平衡来自电子内部的电磁斥力,进而维持住电子自身的稳定性。1911年,M.von Laue进一步指出,带有庞加莱张力的电子,其能、动张量满足相对论提出的协变性要求,表明张力方案与相对性原理相容。话虽如此,对于庞加莱张力的物理本质,人们始终无法说出个所以然来。而且更为糟糕的是,所有针对电子大小所开展的探测活动均以失败而告终。

在玻尔建立起氢原子的结构模型之后,人们便发现就氢原子光谱的解读而言,无需涉及诸如电子的大小或其内部结构这类问题。在海森伯提出矩阵力学之后,物理学家泡利在运用新力学推导氢原子分立光谱的过程中,同样没有涉及电子的任何具体特征。由此看来,无论是玻尔的旧量子论还是后来的量子力学,都将电子约化成了一个没有空间延展性的客体。换句话说,在描述微观世界的客观规律时,可以放心地把电子当作点粒子对待。对此,Y.I.Frenkel给出了一个很好的总结:

(电子的大小及其内部结构问题)之所以产生,是因为人们把一种只能运用于原子等组合系统的分割原则,不谨慎地应用到了作为物质最基本组分的电子之上所产生的结果。电子不仅在物理上是不能分割的,而且在几何上也不能够加以分割。

鉴于此,量子电动力学将电子作为点电荷看待,从而规避了电子自身的结构在电子与电磁场的相互作用中可能带来的复杂性,使理论对于相互作用的描述得以简化。然而美中不足的是,点粒子图像与海森伯的不确定原理一经结合,便产生出高能虚状态问题,最终导致所有的计算过程均给出无穷大这一结果。

除了电子的大小之外,量子电动力学还面临着另一个重要问题——如何描写微观粒子之间的相互作用。在玻尔的氢原子理论中,处在能量较高轨道上的电子,可以通过发射光子的方式失去部分能量而跃迁到能量较低的轨道上去。在此之前,被发射的光子身处何处?反之,处在能量较低轨道上的电子,通过吸收光子的方式增加能量后,也可以跃迁到能量较高的轨道上去。那么被吸收掉的那个光子之后去了什么地方?

实际上,被辐射出来的光子是电子发生跃迁时创生出来的,此前并不存在;被吸收掉的光子被湮灭掉了,之后也不存在。这表明,电子的状态每发生一次改变,都将伴随着光子的产生或者湮灭。对于出现在电子与光子之间的这种相互作用新模式,该如何加以描写呢?

这个问题的最终解决与英国物理学家狄拉克息息相关。1924年前后,狄拉克注意到含时薛定谔方程对于时间的求导是一阶的,而对于空间的求导则是二阶的,时间与空间在此表现出了明显的不对称性,这是个问题。因为根据狭义相对论,时间与空间应该完全对等。带着这个问题,狄拉克进一步注意到,从时间与空间坐标处于同等地位的如下标量方程及其共轭式中:

(□![]() )ψ=0

)ψ=0

□![]()

能够推导出下述连续性方程:

![]()

其中

![]()

![]()

不过,这里的ρ并非正定,因此不能被解释成几率密度。如果想让ρ保持正定,则波动方程在∂/∂t之后就必须是线性的。为此,狄拉克引进四行四列的矩阵来描写电子的运动,最终得到了可以列为二十世纪人类在科学研究领域所取得的最高成就之一的狄拉克方程。该方程除自动包含了电子的自旋运动之外,在满足一定条件的情况下,还能够给出托马斯因子。

不仅如此,狄拉克方程还给出了一个令人匪夷所思的结果:电子可以处于负能量状态。之所以匪夷所思,是因为这样的结果有违物理学常识。但是狄拉克并没有轻易地予以放弃,而是展开了深入思考。一年之后,狄拉克终于理解了负能态的真实含义,并提出了一幅有关电子跃迁的新图景:真空中充盈着大量处在负能态上的电子,如同一个由负能态电子组成的大海。如果海中的电子通过吸收光子获取了足够的能量而跃出大海时,便会在海中留下一个空穴。由于空穴缺少负电荷,因此看起来就像是一个带着正电荷的电子在运动,从而导致电子的跃迁过程表现为光子的湮灭和电子-正电子对的产生。反之,当一个电子回填到空穴里时,先前跃出海面时所吸收的能量得到了释放,致使回填过程表现为电子-正电子对的湮灭和光子的产生。这样一来,最早出现在玻尔理论中的光子产生和湮灭机制,同样适用于电子,由此还催生出了反粒子概念。

于是粒子的产生和湮灭就成为了描写微观粒子之间相互作用时不可或缺的内容。在具体手法上,狄拉克借用了玻恩、海森伯和约当在其发表的《量子力学Ⅱ》一文中将谐振子的量子数n视为振动量子的数目这一思想。对原子系统与辐射之间的相互作用作含时微扰处理时,以自然的方式引进了粒子的产生和湮灭算符。这种方法后来被称作“二次量子化”。

二次量子化与先前所说的点粒子图像结合后,使得在量子场论中,任何两个微观粒子之间的相互作用都不再是一个简单的二体问题,而是—个无限多体的问题。因此,趋于无穷大是量子场论中所有计算过程必然得出的一个结果,进而导致量子电动力学在很长一段时间内无所作为。

直到第二次世界大战结束之后,局面才有所改观。为了解释兰姆位移,朝永振一郎、施温格以及费曼等人以各自独立的方式发展起了一种被称作“重正化”的技术,用于从无穷大的计算结果中提取到有用的信息。

所谓兰姆位移,是指氢原子光谱所表现出来的2s1/2能级的能量稍高于2p1/2能级这一实验现象。按照狄拉克提出的质子-电子相互作用理论,2s1/2与2p1/2这两个能级本该是简并的。1948年9月,朝永振一郎报告了其研究小组针对兰姆位移所做的计算,所得结果是正确的。紧接着,在1949年的年初,施温格和费曼分别发表了各自的计算结果,同样得到了正确的答案。这样,在1949年4月,于纽约以北60公里的哈德逊老石头城举行的学术会议上,重正化处理方案就得到了与会者的基本认可。

然而,时间过去仅仅两年,狄拉克便发表了一篇质疑量子电动力学的论文。他在文中写道:“新近兰姆、施温格和费曼以及其他人的工作是非常成功的……但有关理论是丑陋和不完备的。”在狄拉克看来,所谓的重正化方法既没有一个可靠的数学基础,也没有一个令人信服的物理图景。其实对于狄拉克提出的这两点指责,普通人也不难以理解。从数学上看,重正化要求忽略无穷大量而非有限量,这与数学中的惯常做法正好相反;物理上,以电子磁矩的辐射修正为例,重正化方法认为电子在部分时间里处于离解状态e+γ。其中的γ称作虚光子,它在部分时间里可以离解成轻子-反轻子对,如e-+ e+或μ-+ μ+等。事实上,不仅仅是轻子对,虚光子γ可以离解成任何带电粒子及其反粒子对,并且这些带电粒子对还可以耦合到其他的场,如介子场等。后者也可以发生离解,并且对于电子的磁矩同样有贡献。如此说来,小小的一个电子,其一举一动均可以搅翻宇宙中所有的粒子,这合理吗?

因此,在《量子场论的起源》一文中,狄拉克写道:

我们应当接受这样的观点,目前关于电子与电磁场相互作用的理论必定存在着某些根本性错误。所谓根本性,我的意思是指力学错了,或者是相互作用错了。这个理论错误的程度就像当年玻尔轨道错误的程度一样。

…………

需要有一些新的相对论性方程,还必须引进新的相互作用。一旦构思出这些新方程和新的相互作用,那么今天难倒我们的那些问题就可以迎刃而解了,再无必要使用重正化这类不合逻辑的方法。重正化在物理上是十分荒谬的,我一直反对它。它只能是给出某些结果来的经验算法而已。尽管它取得了一定的成功,但我们还应该准备彻底放弃它。

之所以在意狄拉克所说的这番话,是因为狄拉克不仅是量子场论的创始人,实际上还是重正化方法的创始人。早在1933年,当他抛弃了负能态粒子海,开始转向充斥着不断产生和湮灭着的粒子-反粒子对真空概念时,狄拉克就讨论了真空的极化问题,并提出了将电荷加以重正化处理的思想(不幸遗漏了质量的重正化),这成为了日后发展起来的重正化理论的先导。而作为开创者,狄拉克想必对量子电动力学进行过极其深入的思考,在其观点的背后应该隐含着其他人难以触及的切身体会,因而值得人们格外重视。

事实上,为量子电动力学的建立和完善作出过重要贡献的几位物理学家,在经过后期的深入思考之后,都产生了与狄拉克十分相似的看法。例如,朝永振一郎在1966年曾经说道:

我们的(重正化)方法绝没有真正解决量子电动力学的基本困难。它只是在没有触及基本困难的前提下,给出了处理场效应问题的一种没有歧义的、连贯的方式。

到了二十世纪六七十年代,施温格认为,正统量子场论所采取的方法是首先引入属于虚构性质的结构和相互作用机制,在计算结果出现问题之后再来加以修正,以期获得与实验完全相符的结果。有鉴于此,施温格在1970年和1973年分别发表了论文《粒子、源和场》以及《一份量子电动力学的报告》,文中以数字量子场取代了正统的定域算符场(其中的源象征着对于物理系统进行测量时所引入的干涉)。

因量子电动力学而获得诺贝尔物理学奖的费曼在《QED:光与物质的奇妙理论》一书中,针对量子电动力学所使用的重正化技术写道:

不管这个词听起来多么聪明,我却要说这种处理方法是愚笨的。借助它虽然获得了一些好的结果,但无助于证明量子电动力学在数学上的自洽性。令人不解的是,尽管人们想到了各种各样的办法,但是至今也没能证明量子电动力学的确自洽。我猜想,这是因为重正化在数学上是不合法的。

荷兰裔美国人阿伯拉罕·派斯(Abraham Pais)在其撰写的《基本粒子物理学史》一书中评论量子电动力学所给出的α幂级数展开式的有效性时,提示人们还应该明确了解其适用的界限。而一旦知晓了这个界限,派斯猜想那时的物理学很可能大不同于当前。

6.2 来自实验的困惑

存在于自然界的众多粒子中,有一类被称作轻子的,包括电子、μ子和τ子这三种。除质量外,三种粒子在其他方面完全相同,不分伯仲。由此可知,μ子应该拥有类似于电子反常磁矩的参量,称作μ子反常磁矩。其数值既可以通过实验测量,也可以通过理论计算得到。

实验测量工作起始于1957年。当时,美国哥伦比亚大学的实验物理学家L.M.莱德曼为探讨弱相互作用中宇称是否守恒的问题而研究了π介子和μ子的衰变过程,首次测量出了μ子的g因子等于2.00±0.1。从那以后,欧洲核子中心(CERN)和美国布鲁克海文(Brookhaven)实验室的实验物理学家们对μ子反常磁矩展开了持续的测量。所得结果的相对不确定度目前已达到了10-7量级。

理论计算方面,物理学家们首先是在量子电动力学里,后来又在标准模型的整个框架内对μ子反常磁矩展开了详细的计算,所得结果的相对不确定度目前也达到了10-7量级。不过,虽然在相对不确定度上非常接近,但是来自两方面的结果之间却表现出了明显的差异。

这种情形,在μ子反常磁矩的发展历程中曾经出现过两次。第一次发生在1968年,那时实验测量与理论计算结果之间出现了1.7σ的差距(σ为实验与理论的联合标准差)。后来经过仔细检查,发现针对量子电动力学三圈图所做的计算中存在着错误。校正后,实验与理论计算结果之间就表现出了良好的吻合性。

第二次发生在2001年。当时美国布鲁克海文实验室里的物理学家们得到了精度为1.3×10-6的如下结果:

aμ=0.001 165 920 2(14)(6)

与此同时,理论计算所给出的结果为

aμ=0.001 165 915 96(67)

其相对不确定度更低,仅为0.57×10-6。两项结果之间的偏差达到了43×10-10,而其联合标准差却只有16×10-10,这样偏差就达到了标准差的2.6倍。这种情形出自偶然的概率仅为百分之一,因而引起了物理学界的高度关注。不知为何,这件事被《纽约时报》的记者获悉了,并引起了报纸编辑们的高度重视。随后《纽约时报》在其头版位置报道了这一消息,并冠以骇人听闻的标题:最细小的粒子捅了物理学理论一个大篓子(Tiniest of Particles Pokes Big Hole in Physics Theory)。

事后发现,物理学理论这张大网其实并没有被捅破。因为位于法国马塞的理论物理中心(Centre de Physique Théorique)的M.Knecht等人经过仔细检查后发现,理论计算中有一处错误。在纠正了这一错误后,实验与理论结果之间的偏差是其联合标准差的1.6倍,该结果出自偶然的概率为百分之十一。虽然仍不十分理想,但毕竟将矛盾的尖锐性给暂时平抑下来了。

然而好景不长,到了2004年,当物理学家们对最新的几组实验数据进行分析评定时,得到了μ子反常磁矩的一个新数值:

aμ=0.001 165 920 80(63)

其相对不确定度为0.54×10-6。与此同时,理论计算也给出了新的结果:

aμ=0.001 165 917 90(65)

其具有的相对不确定度与实验结果的几乎相等。但是,存在于两个数值之间的偏差却是显而易见的,使得矛盾再一次变得尖锐起来。

时至今日,实验与理论计算结果本身都只发生了轻微的改变,因此存在于两个数值之间的矛盾并没有得到缓解。有人将这一矛盾称作μ子反常磁矩之谜。谜底在哪儿:测量过程,计算过程,还是有关理论本身?

如果最终确认基本理论是引起矛盾的关键因素,那么狄拉克对于量子电动力学所提出的批评以及该理论的创立者们后来所进行的反思就变得意味深长了。

6.3 并非尾声的尾声

根据第二十四届国际计量大会所通过的有关决议,一旦时机成熟,便将国际科学技术数据委员会(CODATA)所推荐的有关结果指定为普朗克常数、基本电荷、阿伏加德罗常数以及玻尔兹曼常数的准确数值,借此来重新定义质量、电荷、物质的量和热力学温度这几个物理量的基本单位。之所以采用国际科学技术数据委员会提供的结果,是因为人们相信该机构所得出的数据最为可靠。而采用可靠数据的目的,是为了让新、旧定义之间实现完美对接。

不过,说到完美对接,似乎出现了一个问题。因为要真正实现新、旧定义之间的完美对接,那么重新定义国际单位制的基本单位时,就应该采用相关常数“本该有”的数值,而非国际科学技术数据委员会提供的结果。

为什么这样说呢?

现以数学参量π为例来加以说明。对于π,人们最为熟悉的是它的数值介于3.141 592 6与3.141 592 7之间,乃南北朝时期的数学家祖冲之(公元429—500年)通过“割圆术”求算出来的。设想一下,假如人们一直没能寻找到现如今这些可用于计算π的数学公式,那么就只能采用数值3.141 592 6或者3.141 592 7。无论哪种情况,π都只拥有着8位有效数字。对于一般的计算任务而言,8位有效数字就足够了。但在某些特殊场合,仅有8位数字是不够的。举例来说,现打算从拥有14位有效数字的里德伯常数中,通过其定义式

![]()

计算出诸如电子电荷或电子质量这类物理量的数值。由于出现在定义式中的ε0包含着π,而π又只能取近似值3.141 592 6或者3.141 592 7,因此在最终的计算结果中,只有前8位数字方可采用,这实际上令R∞中位于第9至第14数位上的数字失去了意义。

应该说这几位数字是带有一定含义的,否则人们就没必要将所含的有效数位提升到如此高的水平。因此,在通过R∞的定义式计算其他物理量时,有必要将后面几位数字所包含的信息完整地转移到计算结果中去。

由此再回到SI基本单位的重新定义问题。眼下,人们无法确保由CODATA提供的基本物理常数值就是各基本常数本该有的数值,并非3.141 592 6或3.141 592 7之类的结果。因此,不加考虑地运用CODATA提供的数据来重新定义SI的基本单位,极有可能将一些误差带入到新定义的单位系统中,进而导致在新单位下得出的物理学结果包含着一定的误差。而误差的存在无疑会加大对结果的解读困难,甚至是引发误读。

若想避免误读情况的发生,最好的办法就是将有关误差从所得结果中分离出来,进而得到一个本征性数值,尔后再对本征数值加以解读;或者,将物理学冻结在有关常数所处的水平上,不再追求更高的目标。后者有违人类的本性,因此剥离误差,找出本征性数值便是人们到时候必然作出的选择。

既然如此,当初何必要引入误差?因此,在重新定义SI的基本单位时,人们应该尽最大努力采用有关常数本该具有的数值。但问题是,到哪儿方能寻找到这些数值呢?

困难是显而易见的。按照爱因斯坦的说法,用来定义SI基本单位的普朗克常数、基本电荷、阿伏加德罗常数以及玻尔兹曼常数都是些“任意”性结果,不应该存在所谓的“本该有”的数值;无量纲的纯数型常数是可以拥有这类数值的,但由于前文所指出的原因,目前还无法获取这些数值本身。如此说来,问题得到解决的希望很渺茫。

不过,阿伯拉罕·派斯在其撰写的《基本粒子物理学史》一书中,针对有人声索正电子的发现权一事所作出的评论对于“本该有”的数值的找寻工作很可能具有某种启发作用。派斯在书中写道:

很可能有人在安德逊之前就见到过正电子。不过话又得说回来,在牛顿发现引力定律之前,许许多多的人都看到过苹果从树上掉下来。

这句话带给人们的启迪是:有着深刻内涵的物理事件不一定就远在天边而遥不可及,很可能就发生在人们的身边,如“苹果落地”般常见。因此,关注某些司空见惯的现象或触手可及的结果,或许就能有所收获。

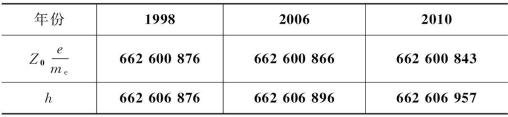

受此启发,现来关注CODATA所推荐的4届基本物理常数推荐值。由于其中的2002届数据在有效数位上既少于此前的1998届,又少于此后的2006和2010这两届,因此暂不予考虑。现从余下3届推荐值中,摘取电子的荷质比![]() 与真空中特征阻抗Z0相乘,并将计算结果所含的数字与普朗克常数所含的数字相比较,如下表所示。

与真空中特征阻抗Z0相乘,并将计算结果所含的数字与普朗克常数所含的数字相比较,如下表所示。

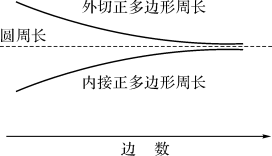

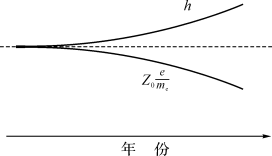

不难看到,同期的两个数字序列的前5位数是完全相同的,后4位数字之间的差异则随着年份的推移而逐渐增大。具体说来,前一个数字序列随着年份的递增而减小,后一个序列则随着年份的递增而增大。这一变化规律很容易让人联想起采用“割园术”求算圆周率π时,外切和内接正多边形周长所表现出来的变化规律:随着边数的增加,外切图形的周长逐渐减小,内接的周长逐渐增大,最后趋同于圆的周长。

倘若将上述图形左右翻转一下,就可以很好地描述![]() 和h所含数字的变化规律:对于1998届数据而言,后4位数字中有3位是相同的,仅有开始的那位不同;在2006届中,相同和不同的数字各占2位;而到了2010届,相同数字一位也没有。

和h所含数字的变化规律:对于1998届数据而言,后4位数字中有3位是相同的,仅有开始的那位不同;在2006届中,相同和不同的数字各占2位;而到了2010届,相同数字一位也没有。

倘若将上述图形左右翻转一下,就可以很好地描述![]() 和h所含数字的变化规律:对于1998届数据而言,后4位数字中有3位是相同的,仅有开始的那位不同;在2006届中,相同和不同的数字各占2位;而到了2010届,相同数字一位也没有。

和h所含数字的变化规律:对于1998届数据而言,后4位数字中有3位是相同的,仅有开始的那位不同;在2006届中,相同和不同的数字各占2位;而到了2010届,相同数字一位也没有。

参照上面的图形,可以说1998届数据是一个汇合性结果,如同圆周长是外切和内接正多边形周长的汇合点一样。这是否意味着1998届的数据可能带有某种特殊性呢?

为此,求取1998届数据中的电子电荷、电子质量以及精细结构常数之间的乘积(仅考虑数值部分):

e×me×α-1 = 1.602 176 462×10-19×9.109 381 88×10-31×

137.035 999 76

=2.000 018 11×10-47

容易看到计算结果所含的数字非常接近于整数2。这一点在该数相对于2所给出的相对偏差

![]()

=9.055×10-6

中也得到了很好的体现。

如果进一步求取1998届数据中的![]() 与h所含数字之间具有的偏差:

与h所含数字之间具有的偏差:

![]()

=9.055×10-6

则所得结果正好是前次偏差值9.055×10-6。这说明在1998届数据下,![]() 与h所含的数字序列相互汇合并不是一个孤立结果,而是一项具有某种代表性的结果。

与h所含的数字序列相互汇合并不是一个孤立结果,而是一项具有某种代表性的结果。

从数据特点上讲,以上内容清楚地表明,1998届数据的确带有某种特殊性。至于这种特殊性与基本物理常数“本该有”的数值之间是否存在着某种联系,以及能否给寻找“本该有”的数值这项工作提供有益的线索,这个问题值得人们考虑。

免责声明:以上内容源自网络,版权归原作者所有,如有侵犯您的原创版权请告知,我们将尽快删除相关内容。